OpenAIのChatGPTやGoogleのBardなど、大規模言語モデル(LLM)は自然言語で人と対話する能力において著しい進歩を遂げました。 ユーザーが言葉で要望を入力すれば、LLMは「理解」し、適切な回答を返してくれます。

研究開発の場で働くリーダーや科学者の中には、ChatGPTを知ってはいても、このテクノロジーが自分たちにとってどんな意義があるのかを明確に理解しているユーザーはそう多くありません。なぜなら、彼らが扱うデータは自然言語ではないからです。 科学的データは一般的なビジネスデータと異なり、特別な取り扱いが必要です。 研究開発データの多くはテキストではありません。 データの種類は時系列、画像、動画、スペクトル、分子構造など多岐にわたり、データソースもフォーマットも無数にあります。

ただ、たとえ一次データがテキストベースでないとしても、どの研究開発ラボにもレポートやコード、設定ファイルなど、テキストを扱う作業は膨大に存在します。

ChatGPTなどのツールを背後で動かしているテクノロジーは、どのラボにも存在するテキストベースのワークフローの負担を大幅に軽減することによって、ラボに新たな自由をもたらします。 さらに重要なのは、ChatGPTの会話コンテキストの劇的な改善を可能にしたAIモデルの進化は、非言語データの関係性をより深く理解するAIの能力も同じように進化させているということです。

これはつまり、イノベーティブな研究開発機関だけがこうした新しいタイプのツールの恩恵を受けられるということです。 LLMは、レポート作成やコーディングなどの煩雑で研究の妨げになるテキストベースの作業の負荷を軽減し、各分野の専門家が最も得意な仕事である「科学」に集中できるようにする可能性を秘めています。

研究開発業務自動化への挑戦

自動化を実現するためには通常、プロセスがほぼ標準化されている必要があります。 最も適しているのは、工場の現場や営業レポートの作成、ビジネス文書の原案作りのように、反復作業が多く、変更の可能性が限定されている、もしくは変更要素がほぼ把握されている組織です。 その点研究開発は、そもそも標準化とは対極にあると言って過言ではありません。 研究開発における自動化の成功とは、人が絶えず介在しなくても、異なる状況に柔軟に対応できるようになることを指します。

新世代の言語モデルが旧世代の言語モデル(SiriやAlexaなどのツールに採用されているもの)と最も異なるのは、会話の文脈(コンテキスト)をはるかに長い間保持できる点です。 LLMは、プロンプトと回答の往復から成る会話の内容を「記憶」することができます。 これは、AIモデルのアーキテクチャの進歩によって、旧世代と同じリソースでもより深く効率的にコンテキストを学習できるようになったためです。

新世代の言語モデルが旧世代の言語モデル(SiriやAlexaなどのツールに採用されているもの)と最も異なるのは、会話の文脈(コンテキスト)をはるかに長い間保持できる点です。 LLMは、プロンプトと回答の往復から成る会話の内容を「記憶」することができます。 これは、AIモデルのアーキテクチャの進歩によって、旧世代と同じリソースでもより深く効率的にコンテキストを学習できるようになったためです。

このテキストベースモデルのイノベーションは、同様に他のデータタイプにもそのまま適用できます。 新たな設計を構築し効率よく学習させることで、時系列データや動画データにおいて因果関係を追跡したり、画像データにおいて空間的関係を認識したりするなど、テキスト以外でも関係性の認識が可能になります。 テキストベースモデルほどマスコミで取り上げられてはいませんが、創薬分野のChemBERTをはじめ、そうしたテクノロジーは既に出現し始めています。 これが成熟すれば、科学データの分析にも同じような質的変化がもたらされると考えられます。

LLMと科学分野のテキストワークフロー

ChatGPTの本質は、単に「次に続く最適な単語」を順番に出力しようとしているにすぎず、1語ずつの積み上げで回答が生成されています。 ある意味、LLMは単なる「精巧なオートコンプリート」です。 したがってこのようなモデルは、半構造化されたテキスト、たとえばコンピューターのコードや設定ファイル、定型的なレポート(さらには、試験問題の解答も!)の作成が得意です。半構造化されたテキストは自然言語よりも予測が容易だからです。 もちろん、これができるようにするには、望まれる出力の適切な例をモデルに学習させる必要がありますが、ChatGPTでは、特別な追加学習をしなくても、一般的なトレーニングデータからコードの例を学習しただけで、主ないくつかのプログラミング言語で簡潔にして実用性の高いルーチンを生成するという、驚くべき能力を実証しています。

半構造化されたテキストは、研究開発の場で頻繁に目にします。 データ分析を実行するアルゴリズムや、実験結果のレポートの一部、ナレッジベースにアクセスするためのSQLクエリなどがその例です。 毎回同じではないにせよ、一般的なパターンや望ましい書式、スタイルが存在します。 従来のラボでは通常こうしたドキュメントの作成は研究者が担っていますが、この作業が存在することで研究者のワークフローは大きく変わってしまいます。 というのも、この間彼らは研究の問題を考えることはできず、コンピューターのコード、データをドキュメントに取り込む方法、データベースへの接続方法について考えなければいけないからです。

研究開発組織のリーダーは、自分たちの科学者、エンジニア、研究者にはそれぞれ科学、エンジニアリング、研究に専念してほしいと考えています。 カリフォルニア大学アーバイン校の研究1によると、一旦別の仕事で集中が途切れると、本来のタスクに再び集中するまでには最大20分を要することが明らかになっています。 LLMベースのツールで対話プロンプトを使って構造化テキストを生成すれば、研究者は高度な研究タスクにもっと集中することができるでしょう。 一般的なオートコンプリート機能でメール文の作成スピードが上がり送信内容に集中できるのと同じように、LLMベースのツールを使うことで、テキストベースの雑多な作業の処理スピードが上がり、より重要なタスクに集中できるようになります。

もちろん、一般的なオートコンプリートを使う場合と同様LLMも間違えることがあるため、現時点ではまだ人間の介在が必要です。

LLMのその先に、トランスフォーマー

こうした柔軟な構造を追跡できるAIモデルを構築するために、AI研究者はAttention(注意)という概念を開発しました。AttentionとはAIモデルの構成要素の一つで、後の出力時に影響を及ぼすと予想される重要な情報を追跡するものです。 過去30年間、さまざまなAttentionメソッドが開発されてきましたが、その中で優秀な成果を挙げていたのは、最近まではどれも比較的複雑なニューラルネットワーク、いわゆるリカレントニューラルネットワークを基礎とするものでした。 リカレントニューラルネットワークは、現在の状態を次の状態の入力に使用します。 情報を順番に積み上げていく必要があるため、アルゴリズム的に学習コストが高く、また複数のマシンで分担して学習することも困難です。

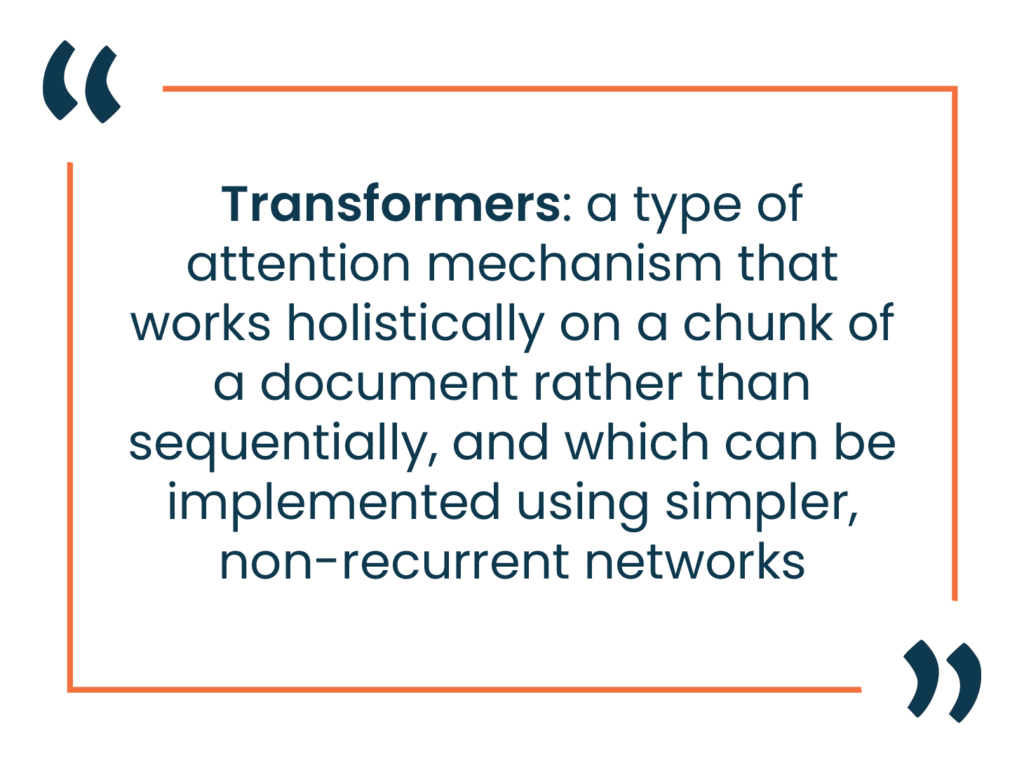

ChatGPTのようなツールの構築を可能にしたブレークスルーが、トランスフォーマーという概念です。これはAttention機構の一種ですが、ドキュメント内のあるまとまった塊(チャンク)を逐次的でなく包括的に処理し、よりシンプルな非リカレントネットワークを使用した実装を実現しています。 モデルを並列的に学習させることが容易になり、アルゴリズムのボトルネックが解消されました。 このモデルでは、より少ないリソースからより多くのトレーニングデータをフィードし、より深いコンテキストモデルを構築できるようになりました。 これにより、現在のLLMは、入力データ量の増加がもたらした幅広い知識の提示と、コンテキスト学習の深化がもたらした人間との会話能力の大幅な向上を実現しています。

しかし、繰り返しになりますが、研究開発データの多くはテキストではありません。 現時点ではChatGPTに画像やスペクトルデータを入力して動かすことはできず、それらのデータを使用するには、まずどうにかしてChatGPTが理解できるテキストデータに変換する必要があります。

AIモデルの視点ではすべてが単なる数値のベクトルでしかないので、トランスフォーマーをベースとするこうしたアルゴリズムの改善は、テキスト以外のデータソースにも適用できるでしょう。 たとえば、コンピュータビジョンや画像処理では、優秀なコンテキストが実現できれば、物体を時間の経過に照らして追跡したり、「近くにある」「左にある」などの位置関係を識別したり、環境的な手がかりを基に事象を区別したりする能力も向上します。 創薬分野では、分子構造データから分子の生化学的特性を予測する能力が急速に向上しています。AIのコンテキスト追跡能力が向上したことで、たとえ分子構造の記述上ではかけ離れていたとしても、連携して特定の化学的特性を生み出す活性サブグループ同士の関係を発見することできるようになります。

今後数年間で、ChatGPTとその仲間を生み出したテクノロジーはますます進化し、科学やエンジニアリングにおけるさまざまなタイプのデータ分析に革命的な変化をもたらすでしょう。

![]() 最新テクノロジーが科学研究にもたらす変化について、詳しくはエンソートの AIスペシャリストによるウェビナー「ChatGPTとLLMについて研究開発リーダーが知っておくべきこと」をご覧ください。

最新テクノロジーが科学研究にもたらす変化について、詳しくはエンソートの AIスペシャリストによるウェビナー「ChatGPTとLLMについて研究開発リーダーが知っておくべきこと」をご覧ください。

関連コンテンツ

研究開発組織の変革を成功させるためのパートナー選び

現在の競争が激しいR&D環境において、適切なテクノロジーパートナーを選ぶことは、組織にとって最も重要な意思決定の1つです。理想的なパートナーとは、単なるツールベンダーやシステムインテグレーターではなく、生産性を向上させ、イノベーションを加速し、競争力を引き出す解決策を提供する科学的な専門知識と戦略的な洞察を兼ね備えた「変革の同志」です。

「AIスーパー・モデル」が材料研究開発を革新する

近年、計算能力と人工知能の進化により、材料科学や化学の研究・製品開発に変革がもたらされています。エンソートは常に最先端のツールを探求しており、研究開発の新たなステージに引き上げる可能性を持つマテリアルズインフォマティクス(MI)分野での新技術を注視しています。

デジタルトランスフォーメーション vs. デジタルエンハンスメント: 研究開発における技術イニシアティブのフレームワーク

生成AIの登場により、研究開発の方法が革新され、前例のない速さで新しい科学的発見が生まれる時代が到来しました。研究開発におけるデジタル技術の導入は、競争力を向上させることが証明されており、企業が従来のシステムやプロセスに固執することはリスクとなります。デジタルトランスフォーメーションは、科学主導の企業にとってもはや避けられない取り組みです。

産業用の材料と化学研究開発におけるLLMの活用

大規模言語モデル(LLM)は、すべての材料および化学研究開発組織の技術ソリューションセットに含むべき魅力的なツールであり、変革をもたらす可能性を秘めています。

科学研究開発における効率の重要性

今日、新しい発見や技術が生まれるスピードは驚くほど速くなっており、市場での独占期間が大幅に短縮されています。企業は互いに競争するだけでなく、時間との戦いにも直面しており、新しいイノベーションを最初に発見し、特許を取得し、市場に出すためにしのぎを削っています。

R&D イノベーションサミット2024「研究開発におけるAIの大規模活用に向けて – デジタル環境で勝ち残る研究開発組織への変革」開催レポート

去る2024年5月30日に、近年注目のAIの大規模活用をテーマに、エンソート主催のプライベートイベントがミッドタウン日比谷6FのBASE Qで開催されました。

科学研究開発における小規模データの最大活用

多くの伝統的なイノベーション主導の組織では、科学データは特定の短期的な研究質問に答えるために生成され、その後は知的財産を保護するためにアーカイブされます。しかし、将来的にデータを再利用して他の関連する質問に活用することにはあまり注意が払われません。

デジタルトランスフォーメーションの実践

デジタルトランスフォーメーションは、組織のデジタル成熟度を促進し、ビジネス価値を継続的に提供するプロセスです。真にビジネスを変革するためには、イノベーションを通じて新しい可能性を発見し、企業が「デジタルDNA」を育む必要があります。

科学研究開発リーダーが知っておくべき AI 概念トップ 10

近年のAIのダイナミックな環境で、R&Dリーダーや科学者が、企業の将来を見据えたデータ戦略をより効果的に開発し、画期的な発見に向けて先導していくためには、重要なAIの概念を理解することが不可欠です。